破解海量網絡安全大數據存儲難題 六步構建高效數據處理與存儲支持體系

隨著數字化轉型的加速,網絡安全領域產生的數據呈指數級增長,日志、流量記錄、威脅情報等海量信息對傳統存儲架構構成了嚴峻挑戰。為破解這一難題,我們通過系統性規劃與實踐,構建了一套高效的數據處理與存儲支持服務體系,其核心可歸納為以下六個關鍵步驟。

第一步:需求分析與架構設計

首要任務是明確業務需求與技術指標。我們深入分析安全數據的類型(如結構化日志、非結構化網絡包)、數據量增長預測、讀寫性能要求、合規保存期限及實時查詢需求。基于此,設計分層存儲架構,將熱數據(高頻訪問)置于高性能存儲(如全閃存陣列),溫數據置于大容量混合存儲,冷數據(歸檔)遷移至成本更低的對象存儲或磁帶庫,實現成本與性能的最優平衡。

第二步:數據標準化與預處理

原始安全數據格式雜亂,直接存儲效率低下。我們建立了統一的數據標準化管道,對來自防火墻、IDS/IPS、終端防護等不同源頭的數據進行解析、清洗、歸一化(如統一時間戳、IP格式、事件類型編碼),并提取關鍵特征。通過流處理技術(如Apache Kafka + Flink)進行實時預處理,過濾噪音,僅將高價值信息存入核心存儲,大幅降低無效存儲開銷。

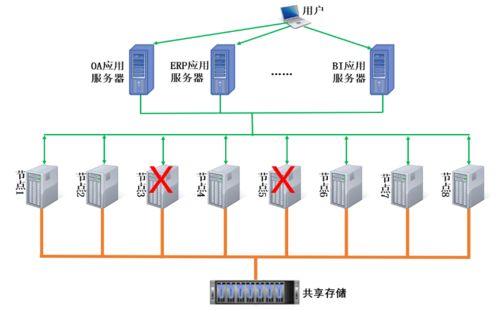

第三步:分布式存儲系統部署

為滿足海量數據擴展性與高可用性,我們摒棄了傳統集中式存儲,部署了橫向擴展的分布式存儲系統。采用HDFS、Ceph或云原生對象存儲服務,構建可線性擴容的存儲池。通過數據分片與多副本機制(通常3副本),確保數據持久性與跨節點負載均衡,即使單節點故障也不影響服務,同時支持PB級容量平滑擴展。

第四步:高效索引與元數據管理

快速檢索是安全分析的關鍵。我們在存儲層之上構建了多級索引體系:對時間、源IP、事件類型等常見查詢字段建立分布式索引(如使用Elasticsearch);維護全局元數據目錄,記錄數據位置、格式、壓縮狀態及生命周期標簽。結合列式存儲格式(如Parquet)優化掃描性能,使千億級記錄下的關聯查詢響應時間從小時級降至秒級。

第五步:生命周期與自動化治理

制定精細化的數據生命周期策略。通過策略引擎自動執行數據流轉:例如,將30天內的熱數據保留在高性能層,30-90天的溫數據轉存至標準存儲,超過1年的冷數據壓縮后歸檔。實施自動化數據去重、壓縮(采用Snappy、Zstandard等算法)與加密,存儲效率提升超60%,并確保敏感數據全程合規加密。

第六步:監控、容災與持續優化

建立全面的存儲健康監控體系,實時跟蹤容量使用率、IOPS、延遲及錯誤率。設置智能預警,在容量達到閾值前自動觸發擴容。構建跨地域或跨云容災方案,通過異步復制實現數據備份與快速恢復。定期基于實際訪問模式調整存儲策略,例如利用機器學習預測熱點數據,動態調整數據布局,實現系統性能的持續優化。

通過這六步閉環實踐,我們成功構建了彈性、高效、可靠的安全大數據存儲基礎。該體系不僅化解了海量數據存儲的物理瓶頸,更通過智能數據處理賦能上層威脅分析、事件調查與態勢感知,真正將數據負擔轉化為安全防御的戰略資產。我們將持續探索存儲計算分離、存算一體等新技術,以應對日益演進的安全數據挑戰。

如若轉載,請注明出處:http://www.lvxingcaicj.cn/product/57.html

更新時間:2026-01-10 11:03:01